JUSTWAVES – !ME(NOTme)

DESCRIPCIÓN

Vista la importancia actual de los medios de expresión visual, presentes en casi todos los festivales de música, y dado que en muchos casos han quedado relegados a un segundo plano, !ME(NOTme) ha buscado reivindicar dicho medio a través de performances en donde la música o sonido esté generada a partir de imágenes y no al revés.

En éste marco ha investigado en varias residencias artísticas, junto con el también visualista Antón Babinski, diferentes maneras de sonificar inputs visuales, usando métodos analógicos así como técnicas y tecnologías actuales (computer vision, live coding,…), creando los proyectos «We are not musicians» y «Chromatic Dissonance // RGBdB».

En éste proyecto «JustWaves», !ME(NOTme) se lanza en solitario a crear una performance de sonido y música experimental, donde todos los sonidos serán generados por los visuales que creará en directo. Éstos serán creados de forma manual con tintas líquidas y reacciones químicas, asemejándose a las técnicas usadas en los años 60-70 en las performances de “Liquid light shows”, pero añadiendo una capa de nuevas tecnologías al proceso.

Como visualista, siempre le ha interesado en la manera en el que nuestro sistema cognitivo interpreta todas las señales externas (ondas), de una manera muy personal. Si bien se puede cuantificar cómo y cuánto de una onda recibimos, no se puede saber cómo cada persona realmente las percibe, entrando en la definición de Qualia, que estipula que las propiedades de las experiencias sensoriales son, por definición, epistemológicamente no cognoscibles en la ausencia de experiencia directa.

Es por tanto que en éste proyecto se explora el mismo concepto a nivel computacional, donde dos programas se intercambiarán datos (ondas digitales), y los interpretarán tanto sonora como visualmente. Las composiciones visuales generadas en vivo, serán grabadas por una cámara, interpretadas por un algoritmo de computer vision programado por !ME, que recogerá datos como colores, formas, movimiento y posición de los elementos visuales, y los enviará a otro programa también realizado por él mismo, que recibirá todos ésos datos y los reinterpretará en sonido.

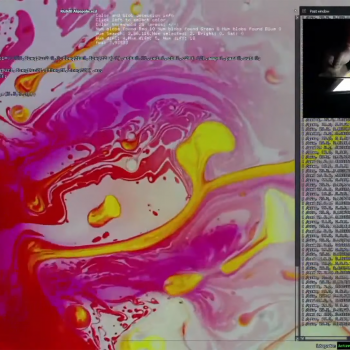

El resultado final que será mostrado en pantalla, se compondrá de las imágenes creadas, junto con el código de sonido que lo interpreta y los datos que están viajando de un programa a otro en el espacio virtual donde habitan ambos. El código que reinterpreta el sonido, creado en supercollider, está pensado para poderse cambiar en directo, realizando prácticas de “Live Coding”. De ésta manera, el público no sólo es partícipe del resultado audiovisual, sino de todo el proceso de cómo se está creando, tanto en la parte “virtual” como en la física.

DURACIÓN DE LA ACTUACIÓN

30-35 minutos.

SE HA PODIDO VER ANTERIORMENTE EN:

- Lux Festival (2023). https://latermicamalaga.com/lux-festival-de-artes-luminicas-de-malaga/

- Festival VIU (2022). Video resumen: https://www.youtube.com/watch?v=9GCRBPNCNz0 Actuación completa: https://youtu.be/UM2ygl0n1Xw?t=7942 (desde 2h.12m.42s a 2h.44m.06s)

- Festival Algopolis (2021). https://www.youtube.com/live/kYW9SSRZAvU?si=VL4CP4xE33qfFcEm&t=15226

- Bits & Bots: https://youtu.be/oihIA6Z_tgk?t=4